近期,科技界传来一则新动态,英伟达携手宾夕法尼亚州立大学及华盛顿大学,共同推出了名为Nemotron-Research-Tool-N1系列的新模型。这一系列模型受到了DeepSeek-R1的启发,并采用了创新的强化学习(RL)范式,旨在增强模型的推理能力。

在大型语言模型(LLMs)领域,通过整合外部工具来提升性能已成为一种流行趋势。这些工具使得LLMs在搜索引擎、计算器、视觉处理及Python解释器等多个领域展现出了卓越的性能。然而,现有的研究方法大多依赖于合成数据集,难以捕捉到明确的推理步骤,导致模型往往只能模仿表面的模式,而无法真正理解背后的决策过程。

为了克服这一挑战,研究者们积极探索了多种策略来提升LLMs的工具使用能力。一方面,他们通过整理数据集和优化模型,创建了大规模的监督数据集,并运用了监督微调(SFT)和直接偏好优化(DPO)等强化学习技术,将LLMs与外部工具相结合,进一步扩展其功能。另一方面,研究者们也在不断改进推理过程,从传统的训练时扩展转向更为复杂的测试时策略。

尽管这些方法在一定程度上取得了成效,但它们仍然受限于合成数据的不足。通过现有的策略,LLMs虽然能够处理单轮或多轮的工具调用,但在自主推理的深度上仍显不足。为了突破这一局限,英伟达及其合作伙伴开发了Nemotron-Research-Tool-N1系列模型。

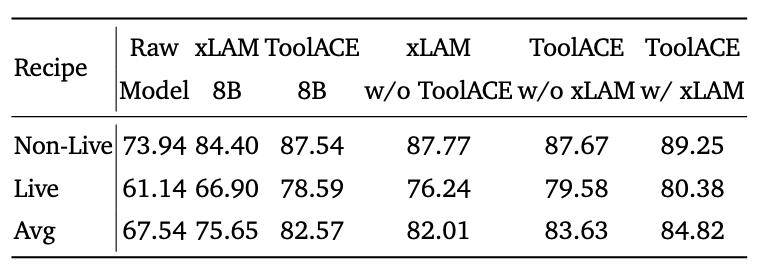

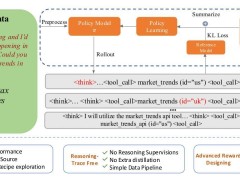

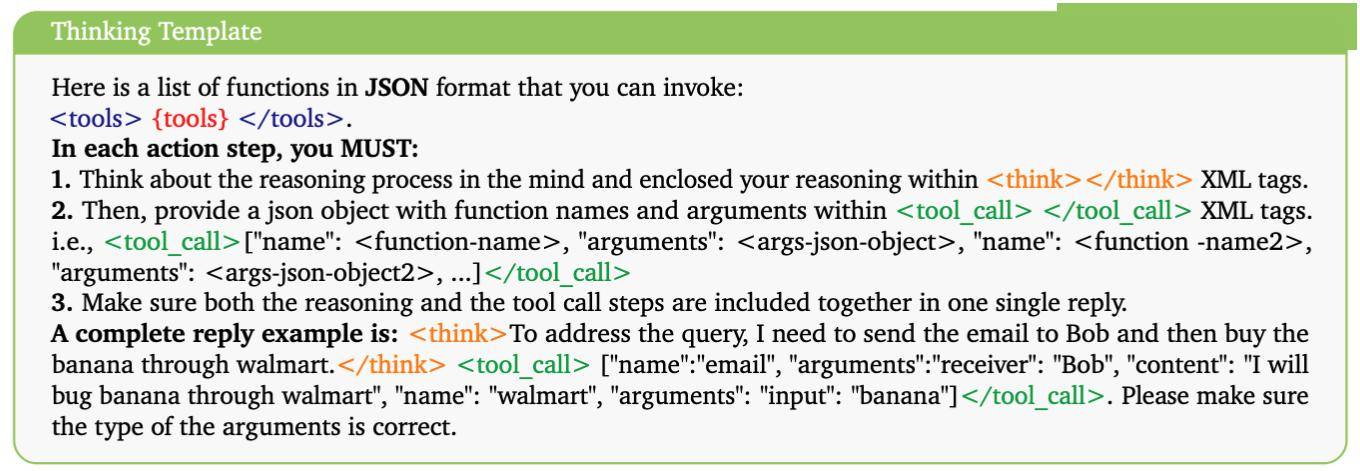

Nemotron-Research-Tool-N1系列模型并未依赖显式的推理轨迹标注,而是采用了一种二元奖励机制,鼓励模型自主发展推理策略。研究者们对xLAM和ToolACE等数据集(包含单轮和多轮工具调用轨迹)的子集进行了统一处理,并设计了一种轻量级的提示模板,以指导工具生成过程。这种模板通过使用特定的标签来明确指示中间推理步骤,并封装工具调用,从而避免了模型过度拟合特定的提示模式。

在模型的主干部分,研究者们选择了Qwen2.5-7B和14B,并测试了LLaMA系列的变体,以评估模型的泛化能力。在BFCL基准测试中,Nemotron-Research-Tool-N1-7B和14B模型展现出了卓越的性能,不仅超越了GPT-4o等封闭源模型,还优于xLAM-2-70B和ToolACE-8B等经过专用微调的模型。

与采用相同数据源的SFT基准相比,Nemotron-Research-Tool-N1系列模型展现出了显著的优势,这充分证明了强化学习方法的有效性。在API-Bank基准测试中,Tool-N1-7B和14B的准确率分别比GPT-4o高出了4.12%和5.03%。这些结果不仅验证了新方法的巨大潜力,还表明LLMs在自主生成推理策略方面取得了重要进展。这一突破标志着从传统的监督微调向强化学习范式的转变。