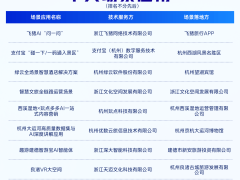

12月初,理想汽车在智能出行领域再度发力,不仅推出AI眼镜Livis,还为VLA(视觉-语言-动作大模型)推送了8.1版本的OTA更新,为用户带来一系列创新功能与体验升级。

此次更新后,用户可通过AI眼镜远程控制汽车空调与后备厢,操作便捷性大幅提升。在车内,用户只需向“理想同学”发出指令,即可轻松规划行驶路线、调整车速。未来,“理想同学”还将具备分析并记忆用户喜好的能力,根据用户偏好设计路线与驾驶风格,甚至能帮用户完成“疯狂星期四”的购买,实现无需下车取餐的便捷服务。

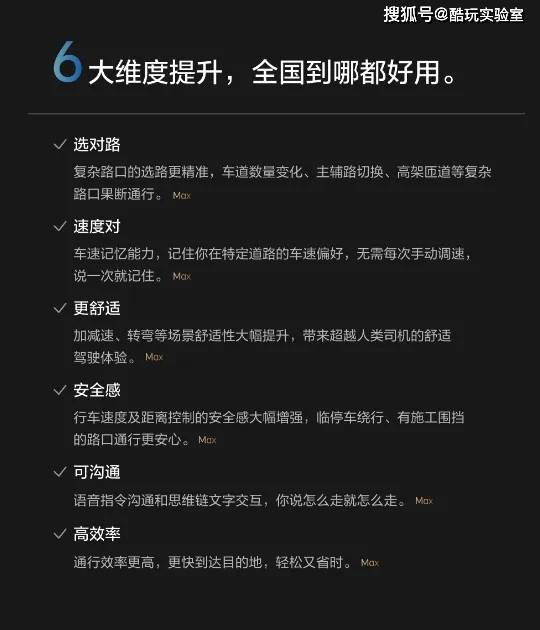

在技术层面,VLA模型的升级尤为显著。其空间感知能力得到拓展,基于扩散模型实现轨迹生成,推理帧率保持在10Hz以上,确保高效运行。对话能力方面,OTA 8.1版本推送后,VLA指令响应速度提升至200毫秒,能更快、更精准地执行行车指令。面对复杂问题,“理想同学”的深度思考时间进一步缩短,对话体验更接近真人。在实际驾驶场景中,VLA在应对施工改道、加塞等情况时,处理更加流畅,减少了猛然加减速、机械式点刹以及变道不及时等问题,提升了驾驶的舒适性与安全性。

扩散模型在轨迹生成方面的优势在于,可直接生成平滑且符合“老司机”驾驶习惯的路线,使车辆行驶轨迹更加果断、自然,辅助驾驶的体验更接近真人操控,有效缓解了用户的不安感。

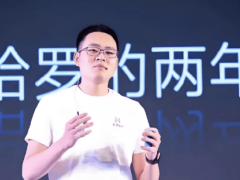

理想自动驾驶负责人郎咸朋表示,理想VLA正以GPT的方式推进自动驾驶技术发展,未来将生成更多接近真人行为的驾驶模式。这一理念源于理想汽车创始人李想对公司定位的深度思考。

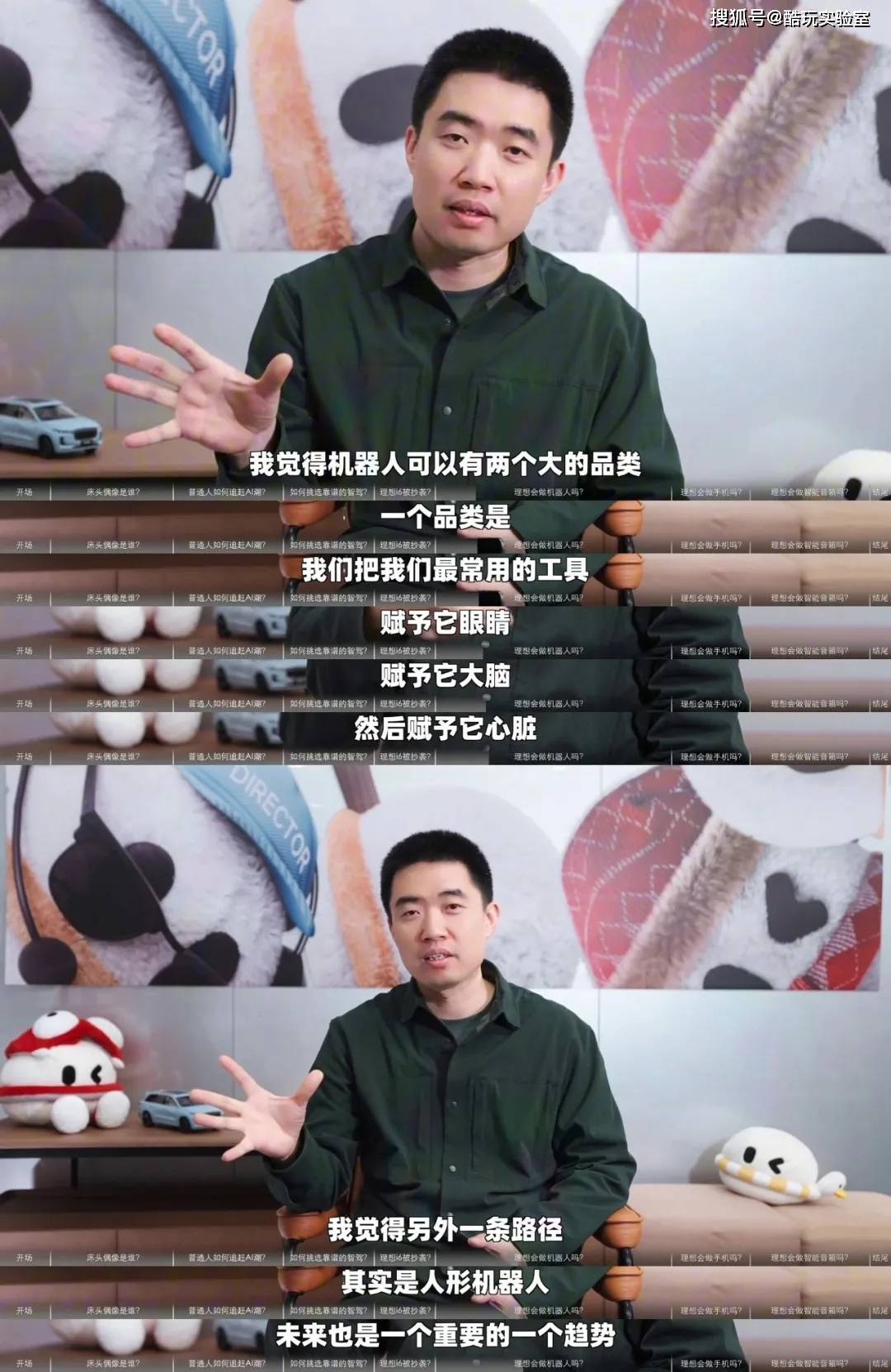

李想认为,具身智能可分为两大类别:一类是人形具身智能机器人,另一类是工具智能化后的具身智能机器人。汽车机器人作为后者,同样具备拟人的思考与行为能力。在理想第三季度财报业绩会上,李想分析了未来十年新产品的发展方向:若产品仅停留在“电动车”阶段,车企将陷入参数竞争的内卷困境,额外研发投入可能成为成本浪费;若产品演变为“智能终端”,车企则会聚焦于屏幕与系统建设,偏离用户需求。因此,理想明确未来路线:不仅要制造电动汽车,更要打造具身智能的汽车机器人,为用户提供全方位的智能服务。

从更广阔的视角看,L4级自动驾驶汽车是行驶在路上的汽车机器人,升级后的智能座舱是具备思考能力的空间智能体,AI眼镜是可穿戴的智能设备,甚至座椅也可通过感知体温、体重,化身健康关怀机器人。这些产品需具备类似人类感官的感知能力与模型能力,以提供私人司机般的专业服务,如开车、停车、充电,以及在车内提供头等舱级别的体验,协助用户处理事务。

回顾技术发展历程,理想此前采用的“端到端+VLM”方案存在一定局限。辅助驾驶缺乏深度思考能力,仅能简单模仿人类驾驶行为,而人类驾驶场景复杂多样,难以通过模仿完全掌握;VLM虽具备视觉能力,但仅能识别常规交通标识,无法对复杂指示牌进行深度分析。这导致用户体验略显僵硬,仿佛车内有教练在指导学员操作。

为突破这些限制,理想将二者整合为VLA模型,推动工具的本体具身智能化。数据显示,人类驾驶时刹车、转向的响应速度约为450毫秒,传统辅助驾驶约为550毫秒,而线控体系可将响应速度缩短至350毫秒,甚至在某些场景下超越人类水平。在感知技术方面,当前广泛采用的3D BEV、OCC占用网络、2D ViT的有效感知距离有限,而3D ViT的工作原理与人类视觉相似,有效距离可扩大两至三倍。未来,理想VLA大模型有望以更接近人类的方式观察环境,更好地理解物理世界,并高效利用人类数据进行训练。其应用场景也将从辅助驾驶扩展至车内外交互,甚至催生更多形态的机器人与应用。

目前,理想VLA已完成软硬件的全面整合,形成技术壁垒,第三方难以提供同级别的AI系统。为保持技术优势,理想坚持全面自研路线,持续加大研发投入。为此,公司架构转型为创业公司模式,聚焦具身智能赛道,重新出发。随着自研芯片、自主泊车、远程呼叫等创新功能的落地,理想将构建一个深度智能、自主服务用户的智能出行生态,为用户带来更多便捷与陪伴。