近日,通义千问在其技术更新中揭晓了两款全新的小型语言模型——Qwen3-4B-Instruct-2507与Qwen3-4B-Thinking-2507,这两款模型以其精简的尺寸和卓越的性能引起了业界的广泛关注。

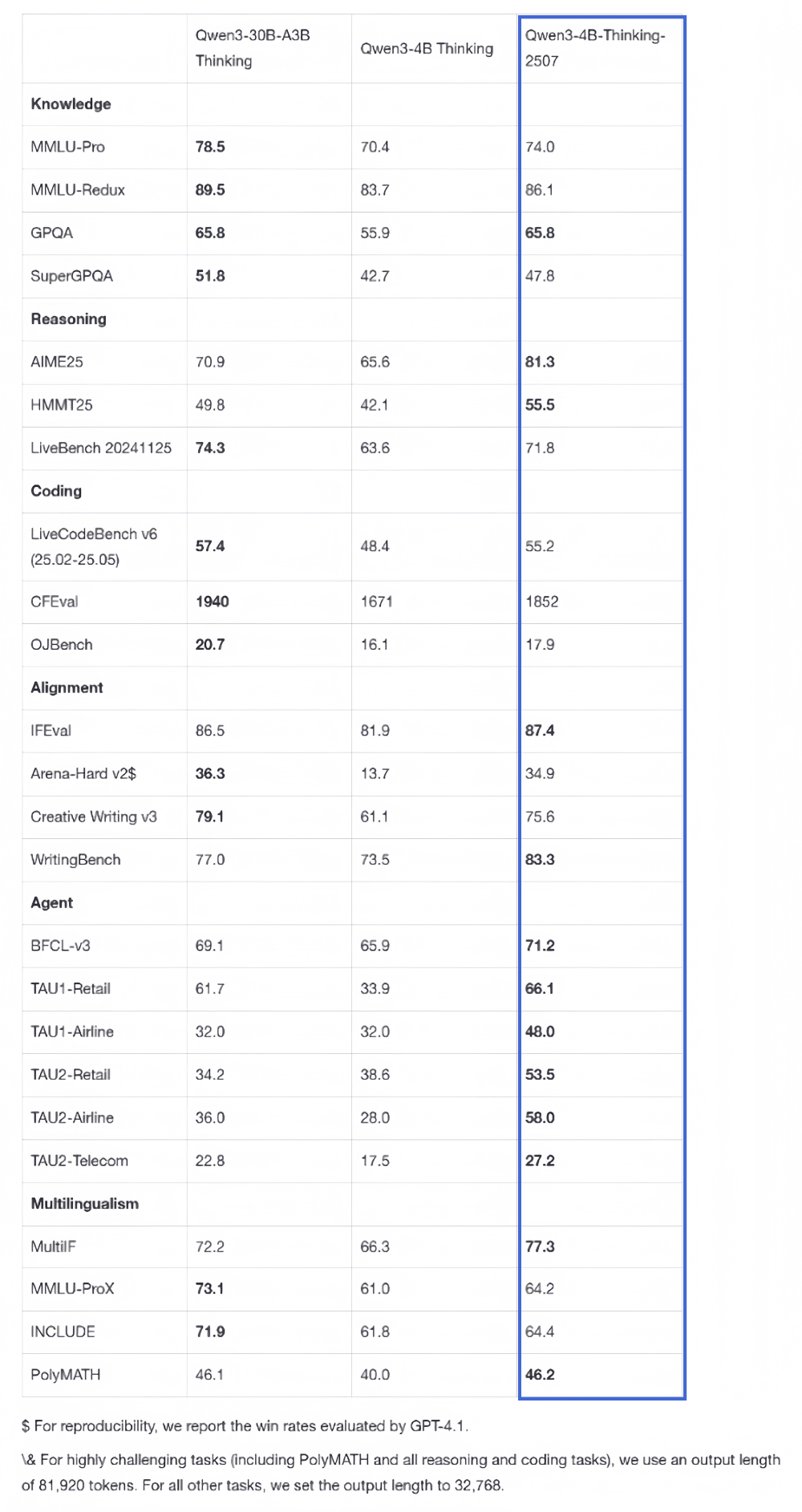

据悉,Qwen3-4B系列的两款新模型在设计上充分考虑了端侧硬件的部署需求,旨在为用户提供更加高效、灵活的AI解决方案。其中,Qwen3-4B-Thinking-2507在推理能力上展现出了与中尺寸模型相当的实力,而Qwen3-4B-Instruct-2507则在知识、推理、编程、对齐及agent能力等多个方面全面超越了闭源的GPT-4.1-nano模型。

这两款新模型的上下文理解能力得到了显著提升,扩展至256K,使其能够处理更长的文本,并支持复杂的文档分析、长篇内容生成及跨段落推理等应用场景。在性能测试中,Qwen3-4B-Thinking-2507在复杂问题推理、数学能力、代码能力及多轮函数调用等方面均表现出色,而Qwen3-4B-Instruct-2507则在Arena-Hard v2基准测试中取得了43.4分的高分。

值得注意的是,Qwen3-4B-Instruct-2507在非推理领域同样展现出了强大的实力,全面超越了GPT-4.1-nano模型,并且其性能已接近中等规模的Qwen3-30B-A3B(non-thinking)模型。该模型覆盖了更广泛的语言知识,与人类偏好在主观和开放性任务中的对齐性得到增强,能够提供更贴近用户需求的答复。

在推理领域,Qwen3-4B-Thinking-2507更是表现出色,其推理能力足以媲美中等模型Qwen3-30B-Thinking。特别是在数学能力的测试中,该模型以4B的参数量取得了81.3分的高分。其通用能力也得到了显著提升,Agent分数甚至超越了更大尺寸的Qwen3-30B-Thinking模型。

通义千问此次推出的Qwen3-4B系列新模型,不仅实现了性能上的优化,更在通用能力上展现出了超越同级别模型甚至逼近中大规模模型的实力。同时,这两款小型语言模型对端侧硬件的友好度也更高,为用户提供了更加灵活、高效的AI解决方案。这一创新举措无疑将加速AI技术在端侧设备的渗透,推动更多轻量化、场景化的智能应用落地。